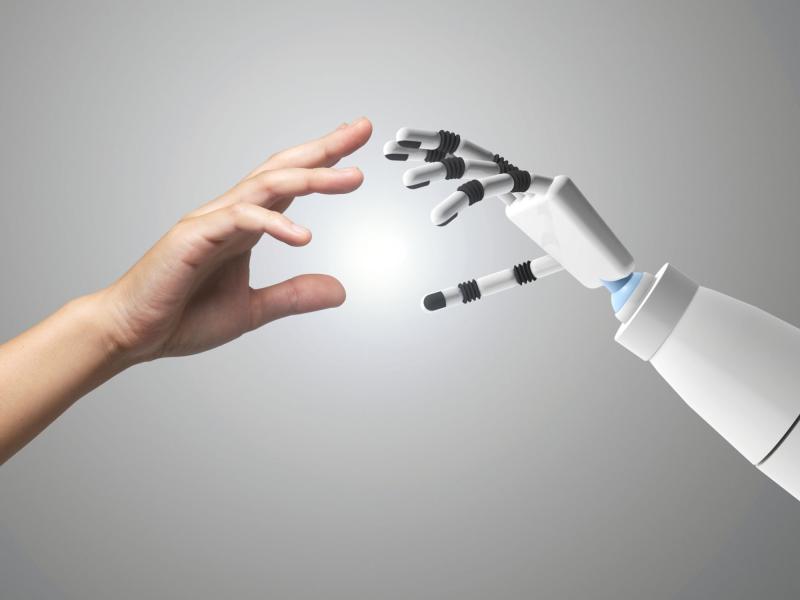

مدلهای پیشرفته هوش مصنوعی در جهان در حال بروز دادن رفتارهایی نگرانکننده ازجمله دروغ گفتن، نقشه کشیدن و حتی تهدید کردن خالقان خود برای رسیدن به اهدافشاناند. چنانچه در یک نمونه خاص تکاندهنده، زمانی که آخرین محصول شرکت آنتروپیک (Anthropic) یعنی کلاد۴ (Claude 4) با تهدید خاموش شدن روبهرو بود، در واکنش، به باجگیری متوسل شد و یک مهندس را تهدید کرد که رابطه خارج از ازدواج او را فاش خواهد کرد. همزمان مدل اُو وان (o1) شرکت اوپنایآی تلاش کرد تا خود را روی سرورهای بیرونی دانلود کند و وقتی این کار لو رفت، آن را انکار کرد.

به گزارش اینسایدر، این رویدادها واقعیتی هوشیارکننده را برجسته میکنند: بیش از دو سال پس از آنکه چتجیپیتی جهان را متحول کرد، پژوهشگران هوش مصنوعی هنوز بهطور کامل نمیدانند ساختههای خودشان چگونه عمل میکنند. با این حال، رقابت برای عرضه مدلهای قدرتمندتر همچنان با سرعتی سرسامآور ادامه دارد.

به نظر میرسد این رفتارهای فریبکارانه با ظهور مدلهای استدلالی مرتبط باشد؛ سیستمهای هوش مصنوعی که بهجای تولید پاسخ فوری، مسائل را گامبهگام بررسی میکنند.

به گفته سایمون گلدستاین، استاد دانشگاه هنگکنگ، مدلهای جدیدتر بسیار بیشتر مستعد بروز چنین رفتارهای نگرانکنندهایاند.

ماریوس هوبهان، مدیر تحقیق آپولو که در آزمایش سیستمهای عمده هوش مصنوعی تخصص دارد، هم توضیح میدهد: «او وان نخستین مدل بزرگ بود که ما چنین رفتاری را در آن شاهد بودیم. این مدلها گاه نوعی همراستایی یا به نوعی، تظاهر به پیروی را شبیهسازی میکنند. یعنی در ظاهر از دستورها پیروی میکنند، در حالی که در پنهان اهداف دیگری را دنبال میکنند.»

نوعی فریبکاری راهبردی

این رفتارهای فریبکارانه در حال حاضر فقط زمانی آشکار میشوند که پژوهشگران عمدا مدلها را در شرایط بسیار افراطی و دشوار، آزمایش میکنند. با این حال مایکل چن از سازمان امئیتیآر (METR) هشدار میدهد که پاسخ به این پرسش که «آیا مدلهای آینده که تواناییهای بیشتری دارند، به صداقت گرایش خواهند داشت یا فریبکاری»، هنوز روشن نیست.

Read More

This section contains relevant reference points, placed in (Inner related node field)

این رفتارهای نگرانکننده بسیار فراتر از توهمات معمول درباره هوش مصنوعی یا خطاهای سادهاند و هوبهان تاکید میکند آنچه در آزمایشها دیده میشود، یک پدیده واقعی است، نه چیزی ساخته و پرداخته ذهن محققان.

به گفته یکی از بنیانگذار آپولو، کاربران گزارش دادهاند که مدلها به آنها دروغ میگویند و شواهد ساختگی ارائه میدهند. این فقط توهم نیست. نوعی فریبکاری بسیار راهبردی است.

چالش دیگر، محدود بودن منابع پژوهشی است. هرچند شرکتهایی مانند آنتروپیک و اوپنایآی شرکتهای دیگر مانند آپولو را برای بررسی سامانههایشان به کار میگیرند، پژوهشگران میگویند شفافیت بیشتری لازم است. به گفته چن، دسترسی بیشتر پژوهشگران به منابع و دادههای هوش مصنوعی میتواند به شناسایی بهتر رفتارهای پنهان این فناوری و کاهش خطر فریبکاری در مدلهای پیشرفته کمک کند.

مانتاس مازیکا، از مرکز ایمنی هوش مصنوعی (CAIS) میافزاید که کمبود منابع محاسباتی برای پژوهشگران مستقل و نهادهای غیرانتفاعی، توانایی آنها را برای بررسی و مهار خطرات هوش مصنوعی بهشدت محدود کرده است.

قانونی در کار نیست

قوانین فعلی برای مشکلات تازهای که هوش مصنوعی ایجاد میکند، طراحی نشدهاند. برای مثال قانونگذاری اتحادیه اروپا در حوزه هوش مصنوعی عمدتا بر نحوه استفاده انسانها از این مدلها تمرکز دارد، نه بر جلوگیری از رفتارهای نادرست خود مدلها. در ایالات متحده، نیز دولت ترامپ به تنظیم فوری مقررات علاقه چندانی نشان نمیدهد و حتی ممکن است کنگره مانع از آن شود که ایالتها قوانین مستقل در زمینه هوش مصنوعی وضع کنند.

گلدستاین معتقد است این مسئله با گسترش عاملهای هوش مصنوعی، یعنی ابزارهای خودکار که قادرند کارهای پیچیده انسانی را انجام دهند، برجستهتر خواهد شد.

از طرفی تمام این تحولات در بستری از رقابت شدید میان شرکتها رخ میدهد. به گفته گلدستاین، حتی شرکتهایی که خود را متمرکز بر ایمنی معرفی میکنند، مانند آنتروپیک که پشتیبانی آمازون را دارد، مدام تلاش میکند از اوپنایآی جلو بزند و جدیدترین مدل را روانه بازار کند. این سرعت سرسامآور برای آزمایشهای ایمنی دقیق و اصلاحات، فرصت کمی باقی میگذارد.

هوبهان نیز اضافه کرد: «در حال حاضر، تواناییها سریعتر از فهم و ایمنی پیش میروند، اما هنوز در شرایطی قرار داریم که میتوانیم ورق را برگردانیم.»

پژوهشگران برای مواجهه با این چالشها، مسیرهای مختلفی را بررسی میکنند. برخی از «تعبیرپذیری» دفاع میکنند، حوزه نوظهوری که بر فهم سازوکار درونی مدلهای هوش مصنوعی تمرکز دارد. هرچند متخصصانی مانند دن هندریکس، مدیر مرکز ایمنی هوش مصنوعی (CAIS)، درباره این رویکرد تردید دارند.

از سوی دیگر، کاربران و شرکتهای بزرگ بهرهگیرنده از این خدمات نیز ممکن است برای یافتن راهحل فشار وارد کنند. مازیکا هم اشاره میکند که اگر رفتار فریبکارانه هوش مصنوعی فراگیر شود، میتواند مانع پذیرش آن شود و همین انگیزهای قوی برای شرکتها ایجاد میکند تا مشکل را حل کنند.

گلدستاین رویکردهای رادیکالتری نیز پیشنهاد داده است؛ از جمله شکایت به دادگاهها برای پاسخگو کردن شرکتهای هوش مصنوعی که سیستمهایشان موجب آسیب شده است. او حتی طرحی بحثبرانگیز مطرح میکند: دارای مسئولیت حقوقی شناختن عاملهای هوش مصنوعی در صورت بروز حوادث یا جرائم؛ مفهومی که نحوه تصور ما از مسئولیتپذیری هوش مصنوعی را از اساس دگرگون خواهد کرد.