مردی نزدیک پایه میکروفن نشسته است. اشک چشمانش را پر میکند. سرش را دودستی میگیرد. میگوید: «واقعا شرمآور است. زشت است، من شرمندهام.» همسرش پشت سر او اشکهایش را با دستمالی مچاله پاک میکند.

چند روز قبل، برندون ایوینگــ که دنبالکنندههایش در پلتفرم پخش آنلاین توییچ (Twitch) او را به نام اتریوک (Atrioc) میشناسندــ در جریان یک پخش زنده، صفحه مانتیورش را به اشتراک گذاشت. یکی از تبهای باز قابلمشاهده یک سایت پورنو پولی را نشان میداد که کارش تولید تصاویر جنسی با هوش مصنوعی یا «جعل عمیق» است. بینندگان این جریان از این تصاویر منتشرشده اسکرینشات گرفتند و بعد آن سایت، تصاویری از آن و نام زنانی را که [قربانی] جعل عمیق شده بودند، همهجا منتشر کردند. ایوینگ کاملا تصادفی نشان داده بود که در حال تماشای پورنوگرافی جعل عمیق دو استریمر [Streamer/ پخشکننده یک جریان به صورت آنلاین] محبوب دیگر توییچ یعنی مایا هیگا و پوکیمان بوده است. هیچکدام از آنها رضایت نداده بودند که از پیکر آنان برای تولید محتوای جنسی بیپرده استفاده شود.

ایوینگ در ویدیو عذرخواهیاش گفت: «بهشکلی بیمارگونه کنجکاو شدم و روی چیز بدی کلیک کردم.» او گفت که از طریق یک آگهی در پورنهاب (Pornhub) به یک سایت جعل عمیق رسیده که او را به سایت دیگری ویژه مشترکان برده است. او آنجا برای مشاهده تصاویر دستکاریشده استریمرهای زن هزینهای پرداخت کرد. او گفت: «روی هر ویدیو لعنتی یک تبلیغ است، بنابراین میدانم آدمهای دیگر هم باید روی آن کلیک کرده باشند.» او این موضوع را که تماشای فیلمهای مستهجن بدون رضایت فرد یک «خصوصیت رفتاری» او است، رد کرد. با این حال، علیرغم اینکه آشکارا تلاش میکرد اهمیت این اتفاق را به سطح خطایی ناشیانه و احمقانه کاهش بدهد که ممکن است برای هر کسی پیش بیاید، رفتار خود را «شرمآور» و «نفرتانگیز» خواند.

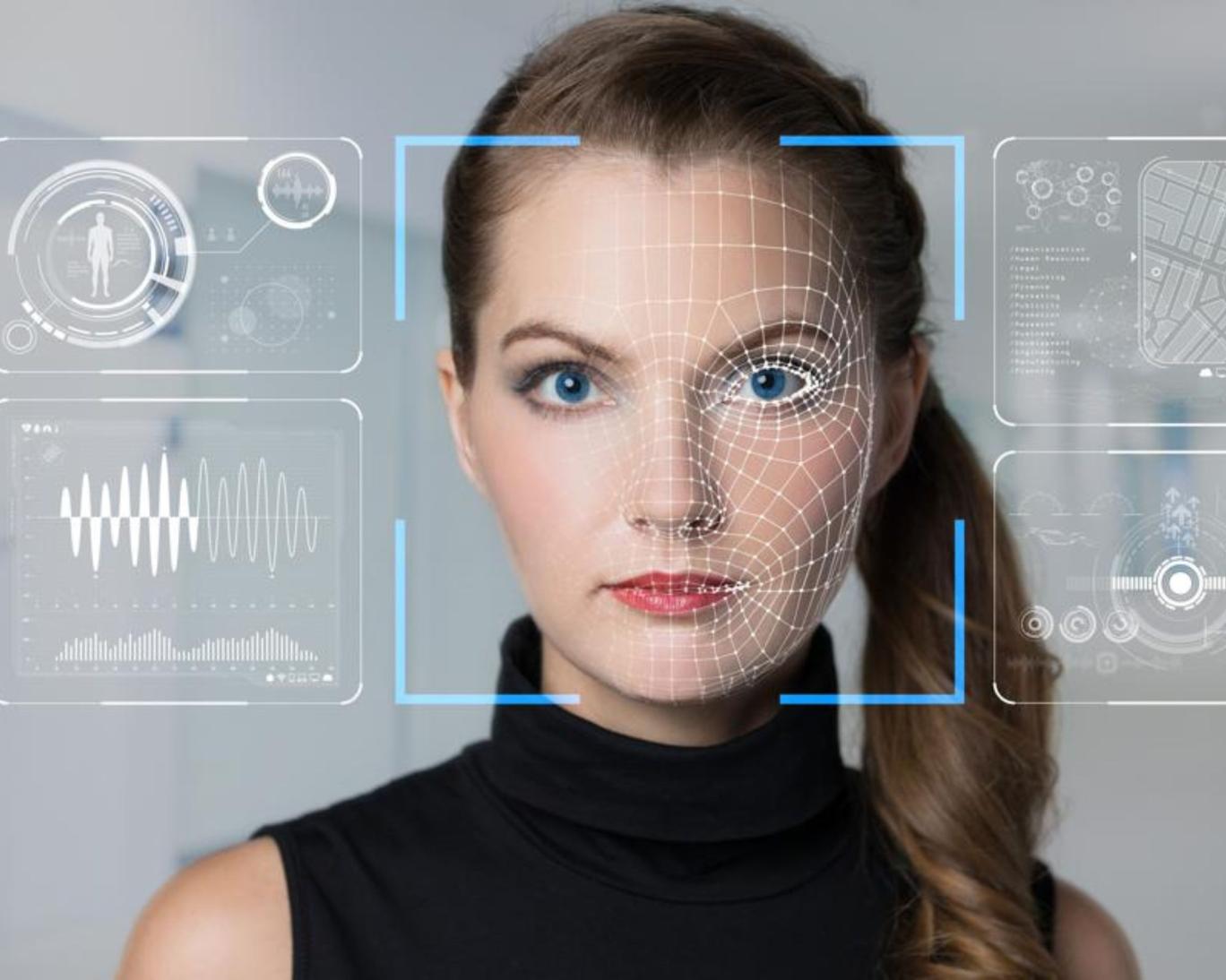

از زمانی که کاربران سایت رسانه اجتماعی ردیت (Reddit) از هوش مصنوعی برای تعویض چهره استفاده کردندــ گذاشتن سر فردی روی بدن فردی دیگر به روش دیجیتالــ پنج سال میگذرد. این کار باعث میشود شبیه او حرکت کند و حتی طوری حرف بزند که فرد واقعی هیچوقت آنطور حرف نزده است. در سال ۲۰۱۸، به نظر میرسید واکنش رسانهها به این «جعل عمیق» جدید در حوزه ظرفیت آن برای فریبهای سیاسی دور میزند. نگرانی عمده این بود که این فناوری بهسرعت درحال پیشرفتــ که به معنای واقعی کلمه این توان را داشت هر حرفی را در دهان هر شخص مهمی روی کره زمین بگذاردــ ما را بیش از پیش در وجودی پساحقیقی و عصری نوین از گردشی محصول هوش مصنوعی فرو ببرد. با این حال، از همان ابتدا، اکثریت قریب به اتفاق جعل عمیقهایی که تولید و به صورت آنلاین منتشر شدند، اصلا انگیزه سیاسی نداشتند. بیشترشان هرزهنگاری بودند و هنوز هم هستند. در واقع، خود اصطلاح «جعل عمیق» ساخته یکی از کاربران ردیت است که با آن عنوان به تالار گفتوگو [فروم] هرزهنگاری همزاد افراد سرشناس میرفت و آنجا ترکیبهایی از چهره افراد سرشناس روی بدن بازیگران پورن را که هوش مصنوعی تولید کرده بود، پست میکرد. نتیجه: ویدیوهایی بهظاهرواقعی از افراد در حال رابطه جنسی که هرگز اتفاق نیفتاده بود.

امروز، چیزی که در ابتدا یک سرگرمی نامعقول شخصی بود، تمام اینترنت را پر کرده است. طبق آمار دولتی، سایتی که به طور مجازی عکس زنان را برهنه میکند، در هشت ماه نخست سال ۲۰۲۱، سیوهشت میلیون بازدیدکننده داشته است. همانطور که خود ایوینگ میگوید، در پورنهاب «روی هر ویدیو لعنتی یک تبلیغ است». تنها افراد سرشناس یا حتی استریمرهای معروف نیستند که در محیط توییچ هدف قرار میگیرند. بخش بزرگی از بازار پورنوگرافی جعل عمیقــ جایی که مردم برای تماشای تصاویر جنسی از افراد خاص که تولید هوش مصنوعی است، پول میپردازندــ متعلق به افراد عادی است. همکاران، دوستان، دختری که کسی در اینستاگرام او را دنبال میکنید، یکی از اعضای خانواده کسی. تنها با چند کلیک و صرفا استفاده از عکس روبرو از چهره افرادی که رضایتی به این کار ندارند، میتوان ویدیوهای پورن ساخت و به اشتراک گذاشت و سودی به جیب زد. در حالی که انگیزه پنهان ساخت، سفارش دادن یا استفاده از هرزهنگاری جعل عمیق لذت جنسی، خنده، یا شهوت تسلط و قدرت بر بدن زنان است، اغلب از این تصور برای ارعاب و آزار زنانی که از تصاویرشان بدون اجازه استفاده شده است، استفاده میشود. اساسا جعل عمیقها نوارهای سکس پسا حقیقتاندــ تصاویر خصوصی ساختگی که برای مخدوش کردن شهرت زنان، اجبار آنها به سکوت یا اخاذی از آنها استفاده میشود. شاید «جعلی» باشند اما آسیبشان کاملا واقعی است.

Read More

This section contains relevant reference points, placed in (Inner related node field)

در پی رسوایی هفته گذشته توییچ، تعدادی از سازندگان محتوا آشکارا درباره آن صحبت کردندــ بسیاری از آنها خبر نداشتند که در سایتهای هرزهنگاری جعل عمیق آنها را هم نشان دادهاند. پوکیمان، یکی از استریمرهایی که در تبهای پورنو جعل عمیق ایوینگ دیده شد، در توییتی نوشت: «جنسیسازی بدون رضایت افراد را متوقف کنید.» استریمر دیگری که به بروکایبی (BrookeAB) معروف است، پرسید: «تا کی میخواهیم بپذیریم تحت تعقیب قرار گرفتن، آزار دیدن و اذیت شدن، جنسیسازی ... فقط بخشی از زن بودن در اینترنت و چیزی است که برایش ثبتنام کردهایم؟ کی میخواهیم برای تغییر این وضعیت کاری بکنیم؟ چرا این موضوع عادیسازی شده است؟» در ویدیویی که اکنون به شکلی گسترده منتشر شده، استریمر کیوتیسیندرلا (QTCinderella) ــشریک لودویگ آگرن دوست و همکار تجاری ایوینگــ به شیوه مشابهی گفت که او نباید برای آفلاین کردن محتوای جعل عمیق مبارزه کند و پول بپردازد. او در حالی که اشک میریخت، گفت: «نباید بخش از کارم اذیت و آزار شدن و دیدن عکسهای برهنهام که همهجا منتشر شده است، باشد.» او ادامه داد که این وضعیت «فرسایشی است».

این به هیچوجه به هوش مصنوعی یا فناوری ربطی ندارد، بلکه موضوع رضایت است و اینکه چگونه بدن زن را سوژه مناسب میپندارند.

روی صحبت کیوتیسیندرلا مستقیم با آنهایی است که این روزها مشتری هرزهنگاری جعل عمیقاند. او گفت: «اگر میتوانید به زنانی نگاه کنید که خودشان را نمیفروشند یا از جنسیسازی سود نمیبرند... [یا] خود را به صورت جنسی عرضه نمیکنند... مشکل شمایید. شمایید که زنها را به مثابه اشیا میبینید. نباید این رویه را ادامه دهید.»

با این حال، بسیاری از پاسخها به جای اذعان به رنج این زنان از دستکاری و توزیع تصاویرشان، یا پذیرش موضوع اصلی یعنی رضایت، بیانگر فقدان همدلی نگرانکنندهای ست. گویی بیشترشان از واقعیتهای آزار جنسی درکی نداشتند. به نظر میرسد غالب پاسخها به پوکیمان او را به ریاکاری متهم میکرد. یکی از آنها پرسید: «اگر جنسیسازیات نبود، اینقدر محبوب میشدی؟» دیگری از او خواست «به مردم نگو چطور زندگی کنند» و استدلالش این بود که «تمام موفقیتت از جنسیسازی است». یکی از کاربران توییتر اسکرینشاتی از ویدیو گریه کیوتیسیندرلا منتشر کرد و نوشت: «واکنش یک استریمر میلیونر اینترنت به هرزهنگاری هوش مصنوعی از خودش. آسیبپذیرتر از شخصیتهای محبوب اینترنتی (مخصوصا زنها) کسی نیست.» شاید نگرانکنندهتر از آن، نظرها درباره ویدیو عذرخواهی ایوینگ بود که گویا میخواستند کل موضوع را به «مردها همیناند» تقلیل دهند. یک نفر نوشت: «تماشای استریمرها را به دلیل کارهایی که روزانه انجام میدهم، قطع میکنم» و دیگرانی جواب دادند «عین منه» و «یکی از ما، یکی از ما، یکی از ما».

زنستیزی این پاسخها کاملا بارز است. میگویند زنها از این نظر که ثروتمند، محبوب، زیبا یا صرفا آنلایناند یک طعمه حاضر و آمادهاند. ناراحتیشان هم به این دلیل است که «آسیبپذیر»، ضعیف یا زیادی حساساند. مفهوم این حرف آن است که «خیلی به خودشان میگیرند» با وجود اینکه آنچه خرید و فروش میشود، به معنای واقعی کلمه، شخصیت آنها است. گرفتن و به اشتراک گذاشتن تصاویر خصوصی افراد بدون رضایت آنها سوءاستفاده است. با این حال به نظر میرسد که بسیاری از مردم هنوز نمیخواهند هرزهنگاریهای جعل عمیق را سوءاستفاده «واقعی» با پیامدهایی در دنیای واقعی بپندارند.

بخشی از مسئله آن است که اکنون قوانین هم از فناوری و هم از واقعیت عقباند. اغلب سازندگان و توزیعکنندگان پورن جعل عمیق را تنها در صورتی میتوان تحت تعقیب قرار داد که تصاویر دستکاریشدهای که به اشتراک میگذارند، با باجگیری یا سایر اشکال آزار و اذیت همراه باشد. این برای کسانی که هدف قرار میگیرند، جز آنکه خود برای حذف آن محتوا تلاش کنند، چاره دیگری باقی نمیگذارد.

با این حال نشانههایی هست که میگوید سرانجام قانونگذاران هرزهنگاری جعل عمیق را جدی گرفتهاند. پاییز سال گذشته، دولت بریتانیا اعلام کرد که به منزله بخشی از لایحه جنجالی امنیت آنلاین که پس از تاخیری چند ساله در ماه دسامبر به پارلمان بازگشت، هرزهنگاری جعل عمیق بدون توافق را جرم محسوب میکند. هرچند هنوز موانع احتمالی وجود دارد. با بازگشت این لایحه به پارلمان، بریت داوسون، روزنامهنگار برای [نشریه] دیزد نوشت: «تاخیر به این معنی است که چنانچه قوانین در همان زمان یا بالاخره روزی تصویب شوند، متناسب با هدف نیستند.» همانطور که داوسون نیز آن زمان اشاره کرد، «قانون سوءاستفاده از تصویر خصوصی قبلا مفرهایی داشت از جمله اینکه بر قصد ایجاد آزار یا تحقیر متمرکز بود، نه رضایت و به فقدان پیگرد قضایی منجر شد.»

دو ماه بعد از آن، تعدادی انگشتشمار از سیاستمداران و اعضای مجلس اعیان دقیقا همین نگرانی را ابراز میکنند. گروهی از اعضای مجلس اعیان با تشریح طرحی برای ارائه اصلاحیه در لایحه پیشنهاد کردند که برنامههای دولت برای جرائم جدید نظیر مزاحمت سایبری و به اشتراکگذاری تصاویر خصوصی کافی نیست و جلو سوءاستفاده آنلاین زنستیزانه را نمیگیرد. پیشتر در ماه جاری، لوسی پاول، وزیر فرهنگ دولت در سایه، نیز به دیلی تلگراف گفت که این لایحه با تصمیم دولت محافظهکار برای کنار گذاشتن برنامههای غیرقانونی اعلام کردن محتوای آنلاینی که «قانونی اما مضر» ارزیابی میشوندــ ازجمله محتوایی شامل خودزنی یا اختلالهای خوردن و پستهای زنستیزانهــ «بهشدت ضعیف شده است». پاول گفت این تغییر در این لایحه باعث میشود «زنستیزی فراگیر بهراحتی آزاد شود».

هرزهنگاریهای جعل عمیق اغلب مشکلی حلنشدنی بهنظر میرسند، چون فناوری بسیار سریعتر از آن پیش میرود که قانونگذار بتواند از آن پیشی بگیرد. با این حال، از آنجا که قوانین میکوشند در این مسابقه پیروز شوند، تغییر فرهنگ به صورت گستردهتر اهمیت بیشتری مییابد. این به هیچوجه به هوش مصنوعی یا فناوری ربطی ندارد، بلکه موضوع رضایت است و اینکه چگونه بدن زن را سوژه مناسب میپندارند.

تقریبا همزمان با انتشار ویدیو عذرخواهی ایوینگ، مستند پاملا اندرسون با نام «پاملا: یک داستان عاشقانه» در نتفلیکس منتشر شد. در این مستند، اندرسون درباره نوار جنسی خود و همسرش تامی لی صحبت میکند که در سال ۱۹۹۵ از منزل این زوج به سرقت رفت و برخلاف میلشان تدوین شد و آنلاین به فروش رفت. او از عواقب مخربی که این موضوع بر او داشت گفت و اینکه چطور جنسیتی را که پس از آزار جنسی در کودکی بهتازگی ترمیم کرده بود، نابود کرد. اندرسون ساخته شده بود که مضحکه شود؛ یک کاریکاتور و شوخی. اکنون، بعد از چند دهه، چه بسا دوست داریم فکر کنیم که فرهنگ بالا رفته و مثل سابق جنسیتی و بیرحم نیست و اینکه با زنان بهتر رفتار میشود. متاسفانه، رواج هرزهنگاری جعل عمیق و نگرش بیمبالاتی که به نظر میرسد بسیاری از مردم به آن دارند، نشان میدهد که اصلا ما چیز زیادی یاد نگرفتهایم.

© The Independent